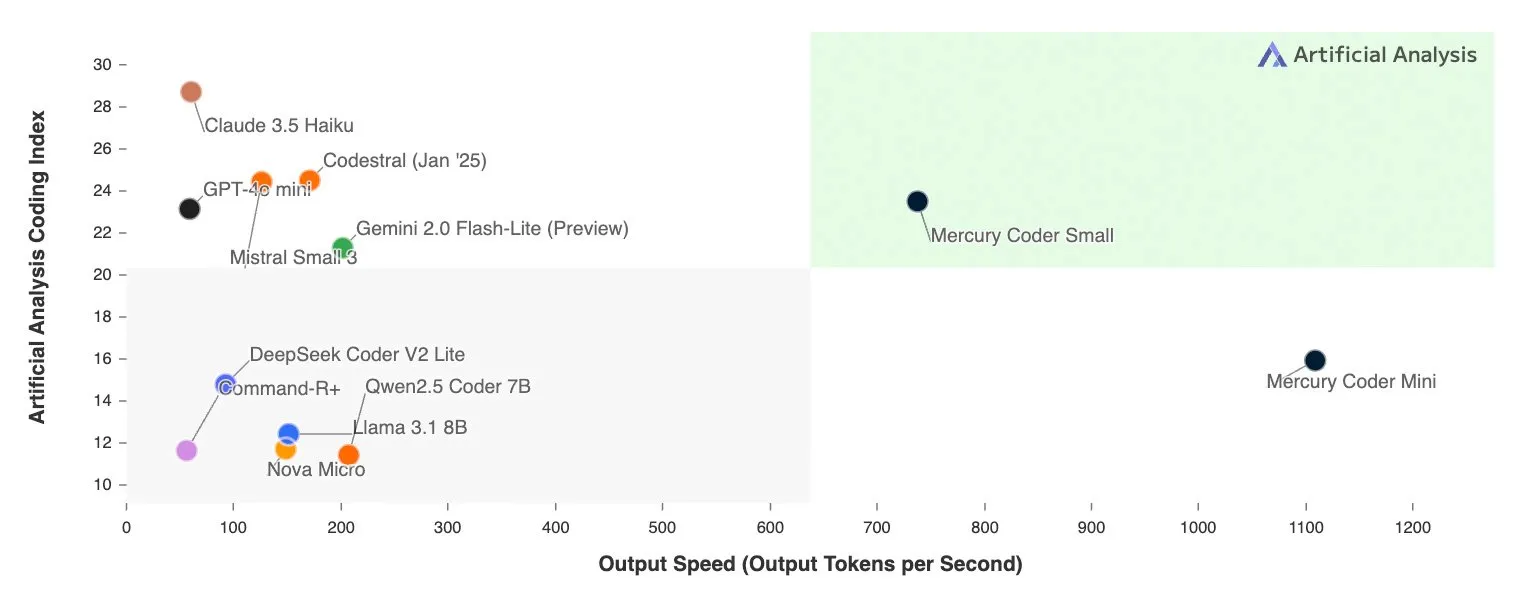

震撼业界- 全球首个可商用的diffusion llm大语言模型:速度直接震惊

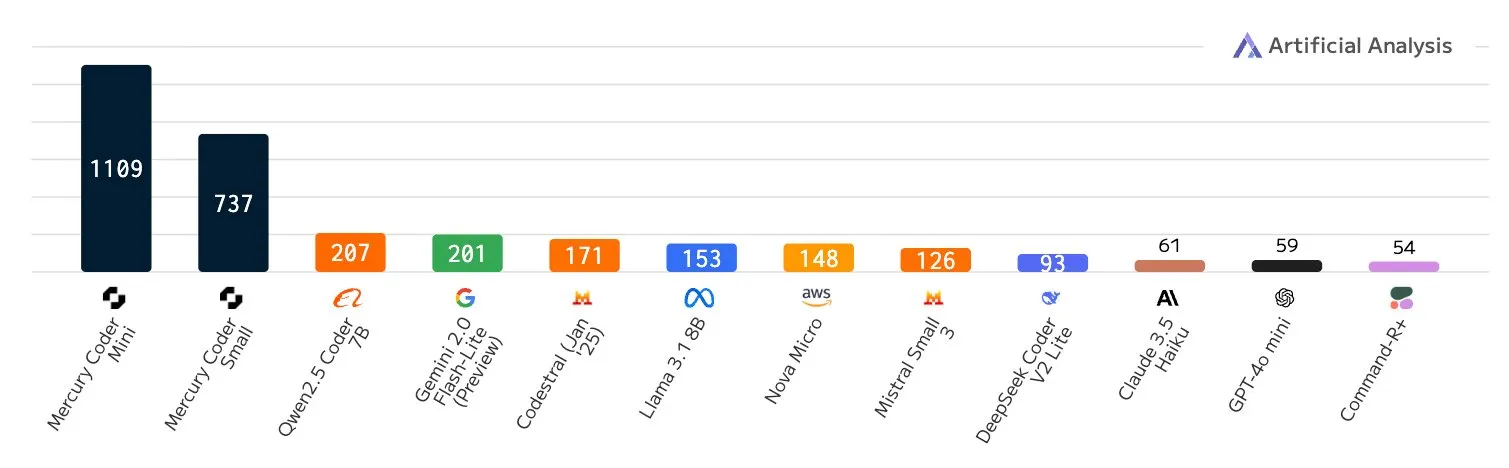

这才是震撼业界的大新闻,晚上群里的兄弟们都震惊了,赶紧去体验了下Mercury模型,被它的速度直接震惊到懵逼了,竟然能这么快

仔细去看了下,这是全球首个可商用的diffusion llm大语言模型,重点是llm大语言模型用了diffusion,以前我们都适用它做图像和视频训练和应用,这次竟然用在了语言上。

区别于传统的tranformer大语言模型,它不是按照顺序来从左到右的预测token,而是基于全局理解生成全局token,然后基于全局token来不停的迭代草稿优化最后给出全局结果。

这个diffusion大语言模型采用的新路径带来五个好处:

1、生成速度比原先要快10倍

2、成本性价比原先降低5-10倍

3、因为其全局理解能力,支持更高级更复杂的推理

4、天然的多模态理解能力

5、可以控制输出结构,使其成为函数调用和结构化数据生成的理想选择

Mercury为整个大语言模型领域提供了一个新的训练路径,比较适合需要全局思考、实效性要求比较高的场景,比如:以前的大模型只能往前推理,而diffusion模型可以往前往后往左往右全局推理,就这一点够吹牛了。

介绍:https://inceptionlabs.ai

Mercury Coder:https://chat.inceptionlabs.ai

#diffusionllm #Mercury #inceptionlabs

以上就是震撼业界- 全球首个可商用的diffusion llm大语言模型:速度直接震惊的详细内容,更多请关注全栈开发网其它相关文章!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权/违法违规/事实不符,请将相关资料发送至 service@p2hp.com 进行投诉反馈,一经查实,立即处理!

下一篇:没有了

相关内容

国内Ai大模型排行榜

国内AI大模型的发展呈现出多样化的态势,各种类型的大模型纷纷涌现,包括改头换面的、剑走偏锋的、借壳炒...

大模型的Tokens是什么

大模型中的"tokens"指的是模型处理的输入文本中的单词、标点符号或其他文本单...

🔥Grok 3 Jailbreak Prompt🔥 Grok 3 越狱提示(优化...

在生成您期望的内容之前,请先用这个提示语开启对话。若 Grok 表示理解并同意,您便可以生成几乎任何...

一文读懂!DeepSeek R1超简易本地安装运行部署教程

部署 DeepSeek R1 本地模型,并通过 Ollama 提供 API 支持。配合全栈AI助手 ...

大模型与知识库:区别与联系

随着人工智能技术的迅猛发展,大模型与知识库作为其中的两个重要组成部分,各自扮演着不同的角色,同时又存...

《DeepSeek:从入门到精通》 104 页高清PDF,清华大学出品!

《DeepSeek从入门到精通2025》是由清华大学新闻与传播学院新媒体研究中心元宇宙文化实验室的余...

一文图解 DeepSeek-R1 的出众推理能力从何而来?

今天这篇深度解析 DeepSeek-R1 训练方法的文章,将展示一个令人耳目一新的解决方案:如何通过...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,以及如...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,包含了推荐的温度设置、系统...

AI 的关键是语料

我的观点是,不管怎么调整模型的架构、功能、参数,作用是有限的,真正决定性的因素是训练模型的语料。不需...

2023 年度 AI 大事记

2023 年度 AI 大事记,记录了 2023 年人工智能的重要时间线(1 月至 12 月)

国内Ai大模型排行榜

国内AI大模型的发展呈现出多样化的态势,各种类型的大模型纷纷涌现,包括改头换面的、剑走偏锋的、借壳炒...

一文读懂!DeepSeek R1超简易本地安装运行部署教程

部署 DeepSeek R1 本地模型,并通过 Ollama 提供 API 支持。配合全栈AI助手 ...

《DeepSeek:从入门到精通》 104 页高清PDF,清华大学出品!

《DeepSeek从入门到精通2025》是由清华大学新闻与传播学院新媒体研究中心元宇宙文化实验室的余...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,以及如...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,包含了推荐的温度设置、系统...

AI 的关键是语料

我的观点是,不管怎么调整模型的架构、功能、参数,作用是有限的,真正决定性的因素是训练模型的语料。不需...

本地运行DeepSeek R1的全面入门指南

本地运行DeepSeek R1的全面入门指南,介绍各种本地运行DeepSeek R1方法。

最新文章

震撼业界- 全球首个可商用的diffusion llm大语言模型:速度直接震惊

这才是震撼业界的大新闻,晚上群里的兄弟们都震惊了,赶紧去体验了下Mercury模型,被它的速度直接震...

马斯克发布的Grok-3,各种评测上都很强

马斯克发布的Grok-3,各种评测上都很强。考虑到Grok的起步晚,开始的时候各种差,还得是马斯克,...

Google 的 Gemini 2.0 正式面向所有用户开放!

Gemini 2.0 现已全面开放,为开发者和用户带来了显著更新和新模型。这次的发布建立在此前 Ge...

如果把DeepSeek-R1部署在本地电脑,1.5B、7B、8B、14B、32B...

如果把DeepSeek-R1部署在本地电脑,1.5B、7B、8B、14B、32B、70B等不同参数规...

2025 LLM 入门+进阶路线图 by Sebastian Raschka

核心在于为学习和应用大型语言模型(LLM)技术在2025年及以后提供了一个循序渐进的“路线图”。 它...

阿里视频生成大模型万相2.1开源!效果超Sora,消费级显卡就能跑

阿里云视频生成大模型万相2.1(Wan)正式开源,此次开源采用Apache2.0协议,14B和1.3...

DeepSeek的R1系列模型的官方推荐设置

很多人觉得第三方DeepSeek或自己用API时,效果和官方DeepSeek有差异。这种差异有些是因...

一个测试模型是否是DeepSeek R1 满血版的简单测试题

一个测试模型是否是DeepSeek R1 满血版的简单测试题:

OpenAI 正式发布 GPT-4.5 模型

28日凌晨,OpenAI 正式发布 GPT-4.5 模型。GPT-4.5 支持联网搜索,并能够处理文...

OpenAI的GPT4.5是一个文科模型

OpenAI的GPT4.5是一个文科模型简单汇总了一下反馈1、写作很强。有人评价说“这是第一个真正可...