MoE模型 vs Transformer模型核心区别

未知

2025-02-28 18:34:17

0

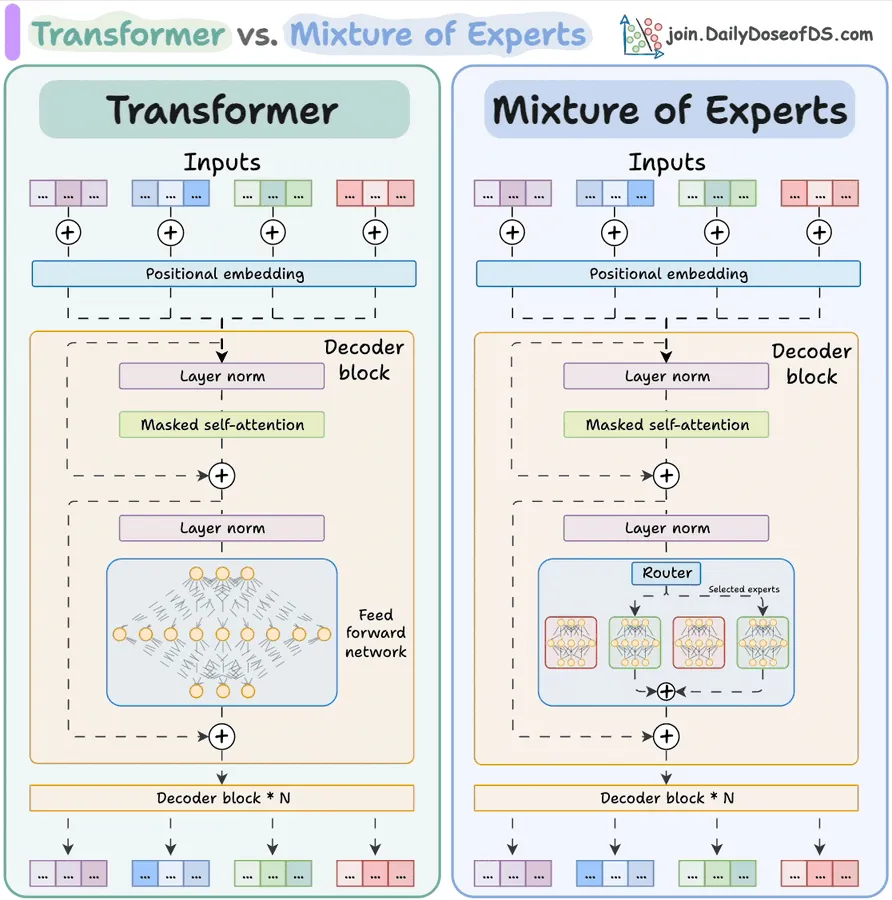

【MoE模型 vs Transformer模型核心区别】:

1. 结构差异

- Transformer:所有输入经过相同的全连接层(每层神经元固定)

- MoE:增加"专家层"(多个小型神经网络)+ 路由系统,自动选择最相关的3-5个专家处理输入

2. 资源使用

- 计算资源:MoE通过稀疏激活(每次只调用部分专家)节省30-60%计算量

- 内存消耗:MoE需要额外存储专家网络参数,内存占用增加约20-40%

- 通信成本:分布式训练时MoE需要专家节点间数据传输

3. 扩展方式

- Transformer:增加神经元数量→参数剧增→计算成本指数上升

- MoE:通过增加专家数量线性扩展,1.7万亿参数模型仅需激活145亿参数/次

4. 应用场景

- Transformer:适合通用任务(如BERT、GPT基础版)

- MoE:更适合多任务/垂直领域(谷歌Switch Transformer已实现7倍效率提升)

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权/违法违规/事实不符,请将相关资料发送至 service@p2hp.com 进行投诉反馈,一经查实,立即处理!

相关内容

国内Ai大模型排行榜

国内AI大模型的发展呈现出多样化的态势,各种类型的大模型纷纷涌现,包括改头换面的、剑走偏锋的、借壳炒...

🔥Grok 3 Jailbreak Prompt🔥 Grok 3 越狱提示(优化...

在生成您期望的内容之前,请先用这个提示语开启对话。若 Grok 表示理解并同意,您便可以生成几乎任何...

大模型与知识库:区别与联系

随着人工智能技术的迅猛发展,大模型与知识库作为其中的两个重要组成部分,各自扮演着不同的角色,同时又存...

大模型的Tokens是什么

大模型中的"tokens"指的是模型处理的输入文本中的单词、标点符号或其他文本单...

2025年国内外AI大模型的API接口网址整理

本文将盘点国内外的知名度较高的AI大模型平台,其中包括AI大语言模型和AI多模态模型,方便大家一探究...

《DeepSeek:从入门到精通》 104 页高清PDF,清华大学出品!

《DeepSeek从入门到精通2025》是由清华大学新闻与传播学院新媒体研究中心元宇宙文化实验室的余...

一文读懂!DeepSeek R1超简易本地安装运行部署教程

部署 DeepSeek R1 本地模型,并通过 Ollama 提供 API 支持。配合全栈AI助手 ...

大模型的max_tokens参数是输出token数吗

在大多数大语言模型的API(如OpenAI的GPT系列、Anthropic的Claude、或国内的一...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,以及如...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,包含了推荐的温度设置、系统...

一文图解 DeepSeek-R1 的出众推理能力从何而来?

今天这篇深度解析 DeepSeek-R1 训练方法的文章,将展示一个令人耳目一新的解决方案:如何通过...

国内Ai大模型排行榜

国内AI大模型的发展呈现出多样化的态势,各种类型的大模型纷纷涌现,包括改头换面的、剑走偏锋的、借壳炒...

《DeepSeek:从入门到精通》 104 页高清PDF,清华大学出品!

《DeepSeek从入门到精通2025》是由清华大学新闻与传播学院新媒体研究中心元宇宙文化实验室的余...

一文读懂!DeepSeek R1超简易本地安装运行部署教程

部署 DeepSeek R1 本地模型,并通过 Ollama 提供 API 支持。配合全栈AI助手 ...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,以及如...

DeepSeek 团队分享了针对 DeepSeek-R1 部署的最佳设置,包含了推荐的温度设置、系统...

AI 的关键是语料

我的观点是,不管怎么调整模型的架构、功能、参数,作用是有限的,真正决定性的因素是训练模型的语料。不需...

本地运行DeepSeek R1的全面入门指南

本地运行DeepSeek R1的全面入门指南,介绍各种本地运行DeepSeek R1方法。

最新文章

OpenAI GPT-4o 上线图像生成功能

OpenAI 宣布为 ChatGPT 推出图像生成功能:“将迄今最先进的图像生成器集成至 GPT-4...

混元-T1: 强化学习驱动,业内首个超大规模混合Mamba推理模型正式发布

强化学习在大语言模型的后训练阶段开创了新的Scaling范式,这一突破正日益受到业界重视。随着Ope...

多个大模型常用的搜索api插件分享

推荐谷歌搜索插件、exa search api和firecrawl搜索API工具。exa提供精炼ht...

通俗易懂说清楚什么是MCP

这两天随着 Manus 的爆火,MCP 也被大家频繁提及,那 MCP 到底是什么?说的通俗点,它就是...

OpenAI 今天又发布了一批新功能,这次是三个音频模型API

OpenAI 今天又发布了一批新功能,这次是三个音频模型API,个人觉得挺实用。新音频模型一览这次发...

用Gemini翻译文章的优缺点及注意事项

用Gemini翻译文章的优缺点及注意事项,Gemini优点是上下文超长,翻译完成度极高,优化Prom...

中国信通院发起大模型幻觉测试,总体涉及五种测试维度

据「中国信通院」公众号消息,中国信息通信研究院人工智能所基于前期的 AI Safety Benchm...

大模型的上下文窗口大小是什么

大模型的上下文窗口大小是什么在中文语境中,“大模型的上下文窗口大小”指的是大型语言模型(如我这样的G...

中国Deepseek为何震惊了国内外,特别是美国人?

中国Deepseek为何震惊了国内外,特别是美国人?

DeepSeek R1 系统提示词

DeepSeek R1 系统提示词:您是由中国公司深度求索(DeepSeek)独家开发的智能助手De...